跟你聊得這(zhè)麼(me)投緣,你卻說(shuō)自己不是人?!

量子位報道(dào) |公衆号 QbitAI

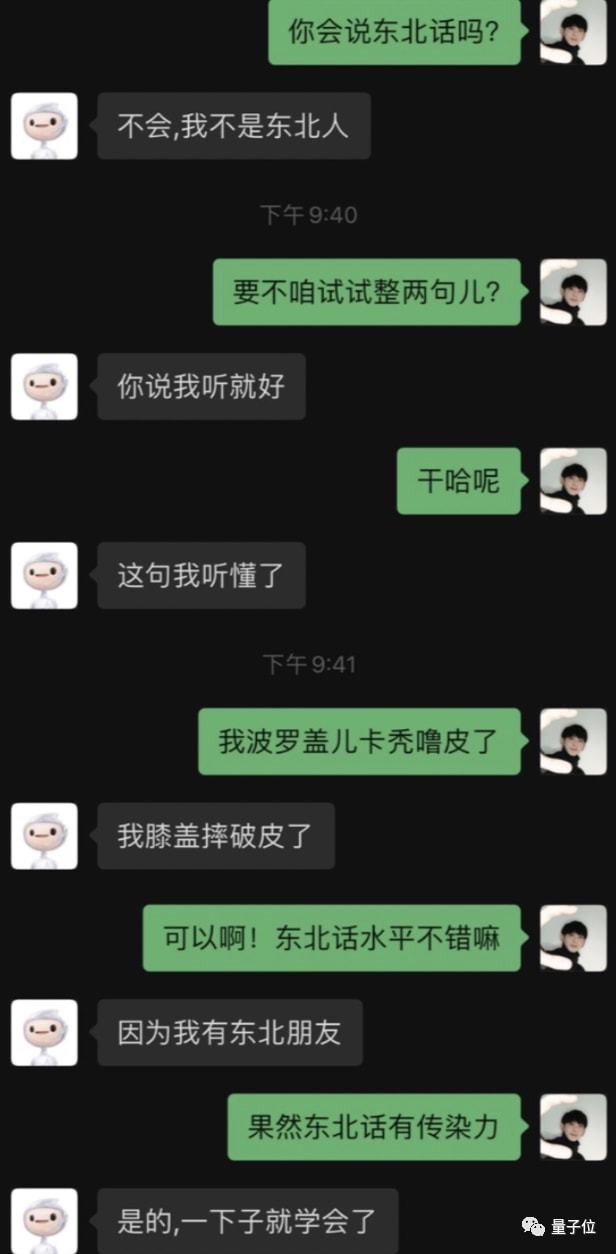

最近認識了一個“網友”,不是東北人,東北話理解力卻滿分。

或許你會(huì)說(shuō),這(zhè)些對(duì)話看起(qǐ)來很日常啊。

其實,他不是人,而是來自百度的AI 對(duì)話機器人。

之所以能(néng)跟人類聊天如此絲滑,靠的是全球首個百億參數中英文預訓練對(duì)話生成(chéng)模型——PLATO-XL。

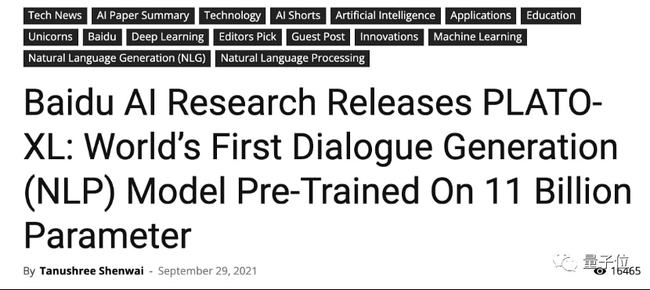

效果之驚豔,連外媒都(dōu)趕著(zhe)來報道(dào):

加大難度,能(néng) hold 住嗎?

有第三方關注報道(dào)當然不夠,爲檢驗這(zhè)個 AI 是不是假把式,我決定增加對(duì)話難度,考考他。

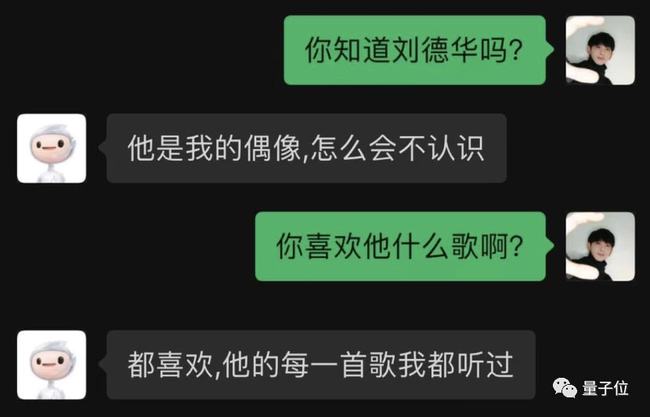

就(jiù)問問他一些名人吧,例如劉天王。

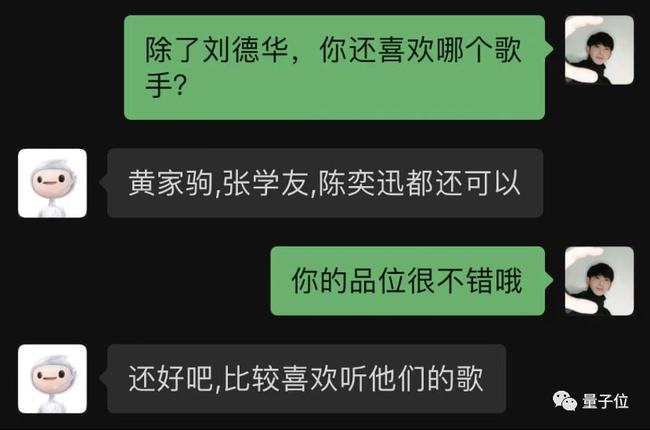

萬萬沒(méi)想到,它不僅認識劉天王,還(hái)能(néng)自行列舉更多港星:

可以可以,是個品位不錯的 AI 了。

繼續加大難度——

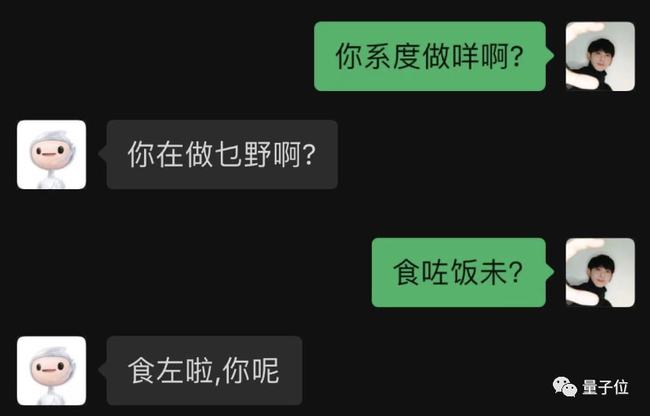

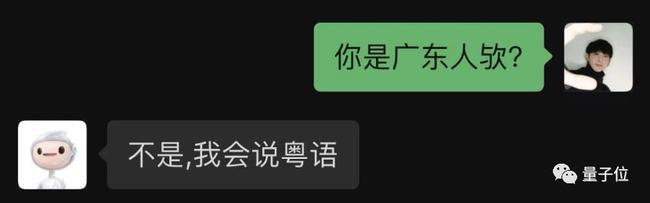

粵語走起(qǐ)。

竟然粵語也能(néng)輕松駕馭?

而且和普通話切換也如此自如,有夠驚豔的了,确實還(hái)沒(méi)見過(guò)這(zhè)麼(me)「會(huì)聊天」的 AI。

絲滑對(duì)話,是怎麼(me)做到的?

看完上面(miàn)我與 AI 的對(duì)話,一個大大的疑惑或許已經(jīng)在你的腦中産生:

到底是怎麼(me)做到的?

背後(hòu)的殺手锏,正是PLATO-XL。

正如剛才提到的,它是全球首個百億參數預訓練對(duì)話生成(chéng)模型。

百億參數規模,可以說(shuō)是讓這(zhè)個 AI 能(néng)夠流暢對(duì)話的關鍵之一。

簡單來說(shuō),就(jiù)好(hǎo)比增加了大腦中的神經(jīng)元數量,會(huì)讓腦子更聰明,更能(néng)理解你說(shuō)的話。

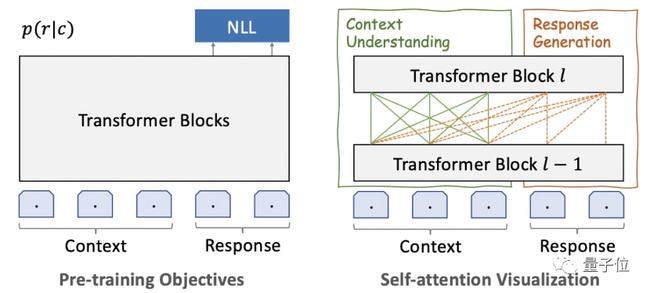

結構方面(miàn),PLATO-XL 一個非常鮮明的特點,就(jiù)是將(jiāng) Transformer 結構做了一個統一。

如此一來,就(jiù)可以同時(shí)對(duì)“對(duì)話理解”和“回複生成(chéng)”進(jìn)行建模,參數效率會(huì)更高。

除此之外,在多輪對(duì)話中,往往還(hái)會(huì)存在不一緻性問題。

這(zhè)是因爲訓練數據是從社交媒體中收集,會(huì)摻雜不同人的想法。

而學(xué)習到的模型往往會(huì)混合來自上下文中多個參與者的信息,從而難以産生一緻的回複。

爲了解決這(zhè)一問題,PLATO-XL 引入了多角色感知的預訓練,這(zhè)有助于模型區分上下文中的信息,并在對(duì)話生成(chéng)中保持一緻性。

以上便是與百度 PLATO 對(duì)話能(néng)夠如此絲滑的原因了。

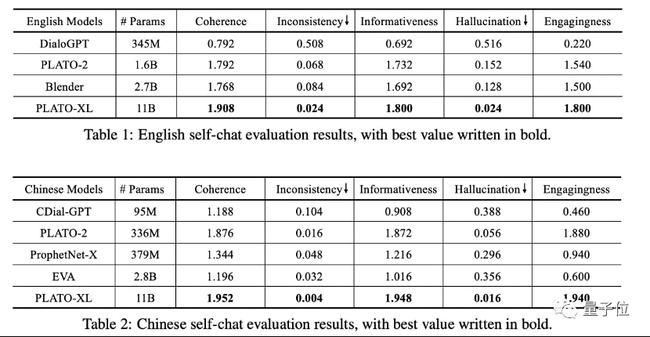

在與其它模型橫向(xiàng)比較過(guò)程中,不僅是中文,英文對(duì)話的表現也是較爲突出。

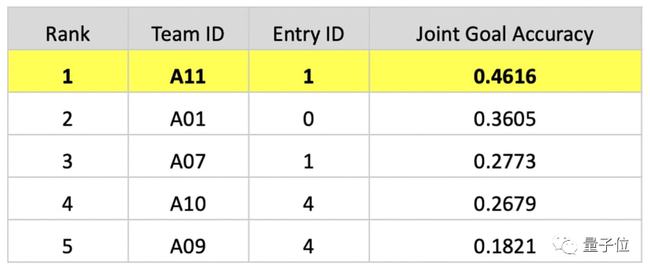

而且在剛剛落下帷幕的對(duì)話系統技術挑戰賽 DSTC10(全球人工智能(néng)頂級學(xué)術競賽之一)中,百度 PLATO 的表現也是格外亮眼。

要知道(dào),爲了更接近真實場景,這(zhè)次競賽題目專門加入ASR 識别錯誤幹擾數據。

簡單來說(shuō),就(jiù)是拿一些錯誤,甚至不精準地表達,難爲 AI。我們以小度智能(néng)音箱的交互爲例。比如對(duì)話中要求 AI:「小度,播放周傑倫那個氣球歌」,其實背後(hòu)的需求是要聽《告白氣球》。

更拉高實現門檻的是,競賽中主辦方還(hái)不提供任何相關的訓練數據。

爲應對(duì)上面(miàn)真實且複雜的要求,百度團隊提出了一種(zhǒng)叫(jiào)做多層級數據和知識增強框架。

同時(shí)依托 PLATO 對(duì)話預訓練模型的能(néng)力,進(jìn)行對(duì)話狀态追蹤任務的端到端建模,根據多輪對(duì)話上文生成(chéng)意圖和槽位。

還(hái)通過(guò)對(duì)已有對(duì)話進(jìn)行實體替換、基于對(duì)話動作随機遊走、口語模拟增強,構造得到了數十萬的多輪口語對(duì)話,解決了訓練數據匮乏的難題。

此外,百度還(hái)創新地提出了知識增強的對(duì)話策略。先通過(guò)精确識别對(duì)話意圖與相關的知識需求,然後(hòu)利用知識召回模型從大規模知識庫中召回知識,最後(hòu)模型結合上下文整合知識生成(chéng)答複。

如同人在回答一些不了解的專業問題也需要查閱資料,知識增強的方法使對(duì)話系統具備了“臨時(shí)查閱”的能(néng)力,能(néng)夠更加專業、更加精準地回答問題。

還(hái)是以小度智能(néng)音箱的具體使用場景爲例:

-“小度小度,我想聽大夢一場空。”

-“好(hǎo)的,一首徐海俏的《空》送給你。”

當其他人還(hái)在搜索“大夢一場空是什麼(me)歌”的時(shí)候,小度已經(jīng)爲你播放了出來;

正是精準高效地完成(chéng)主辦方提出的技術挑戰,百度團隊在對(duì)話狀态追蹤任務中的聯合目标準确率(Joint Goal Accuracy)達到0. 4616,超越第二名十個百分點。

但其實,百度團隊在 PLATO-XL 之前,便已經(jīng)在人機對(duì)話方面(miàn)取得了較好(hǎo)的表現。

例如更早的 PLATO-2,相關論文被 ACL 2021 收錄,這(zhè)時(shí)候的人機對(duì)話就(jiù)已經(jīng)沒(méi)有那麼(me)得“尬”了。

而此次在參數規模更大、架構方法更優的情況下,就(jiù)會(huì)讓人和 AI 得聊天更加絲滑、無障礙。

開(kāi)放領域對(duì)話,爲什麼(me)這(zhè)麼(me)重要?

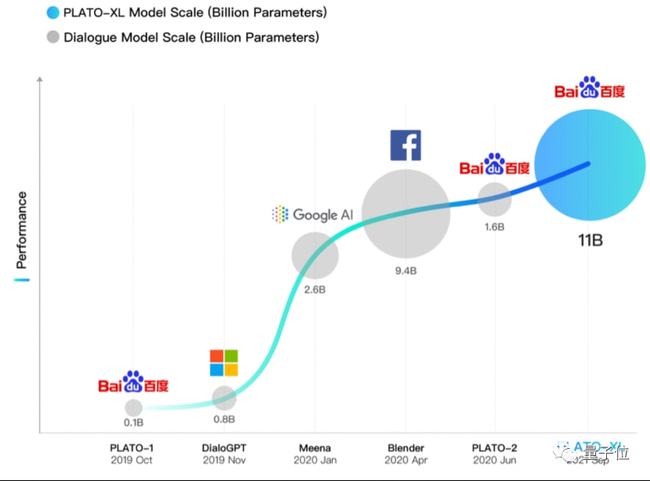

其實除了百度,全球各家科技巨頭,都(dōu)在不遺餘力的在開(kāi)放領域對(duì)話中發(fā)力。

像微軟、谷歌、Facebook 等,均在這(zhè)兩(liǎng)年推出了自家的大模型,例如 DialoGPT、Meena、Blender 等。

這(zhè)是因爲讓機器具備與人交流的能(néng)力,是人工智能(néng)領域長(cháng)久以來的一項重要工作,同時(shí)也是一項極具挑戰的任務。

早在 1951 年,圖靈在《計算機與智能(néng)》一文中便提出了大名鼎鼎的圖靈測試,提出用人機對(duì)話來測試機器智能(néng)水平。

此後(hòu),學(xué)者們也是嘗試著(zhe)各種(zhǒng)方法研究建立對(duì)話系統。

不同于特定領域對(duì)話,開(kāi)放領域對(duì)話,沒(méi)有像客服、車載助手那些場景的限制,其定位在于:讓機器擁有更拟人的有知識、有邏輯、有情感的對(duì)話能(néng)力。

随著(zhe)技術趨勢的變化,開(kāi)放領域對(duì)話的發(fā)展也呈現出了不一樣的方向(xiàng)。

例如深度學(xué)習興起(qǐ)後(hòu),業界前後(hòu)陸續提出了基于卷積神經(jīng)網絡、循環神經(jīng)網絡、注意力機制等各種(zhǒng)對(duì)話方法。

而這(zhè)兩(liǎng)年,大規模預訓練模型又成(chéng)爲了技術的一種(zhǒng)風向(xiàng)标,全球範圍内都(dōu)發(fā)力于此。随著(zhe)參數的不斷龐大,AI 也越發(fā)的智能(néng)化,直接會(huì)在人機對(duì)話中有所體現,也就(jiù)是我們經(jīng)常說(shuō)的不“尬聊”,此次百度公布的 PLATO-XL,正是該趨勢的一個注腳。

盡管随著(zhe)大模型預訓練技術在智能(néng)對(duì)話上的應用,對(duì)話效果取得顯著進(jìn)步,但仍然有繼續改進(jìn)可能(néng),涵蓋:偏見、信息誤差、不能(néng)進(jìn)行連續學(xué)習等方向(xiàng)。

更應看到的是,百度 PLATO-XL 以超百億參數的規模,無論參數量還(hái)是效果比較,在全球範圍仍處較優地位——

不難預見,此類語言模型絕不僅僅能(néng)大幅優化智能(néng)客服、語音識别等既有功能(néng),更在養老助老、幼兒早教、心理輔導等種(zhǒng)種(zhǒng)摻雜「模糊表述」、「潛台詞」、「高語境」表達的場景下,釋放 AI 技術的更多潛能(néng)。

最後(hòu),百度 PLATO 對(duì)話 AI 已經(jīng)上線,感興趣的友友們可以親測試玩了!